全球15家AI芯片公司同時(shí)現(xiàn)身市場(chǎng), 這是15年來(lái)半導(dǎo)體行業(yè)從未有過(guò)的奇景

編者按:本文來(lái)自機(jī)器之能(ID:almosthuman2017),編譯:王宇欣、陳韻竹、Rik R,編輯:宇多田,來(lái)源:EE Times。36氪經(jīng)授權(quán)轉(zhuǎn)載。

對(duì)于人類社會(huì),深度神經(jīng)網(wǎng)絡(luò)就像是那遙遠(yuǎn)地平線上出現(xiàn)的海嘯一般。

鑒于它們的算法和應(yīng)用目前仍在不斷演變,所以尚不清楚深度神經(jīng)網(wǎng)絡(luò)(DNNs)最終將會(huì)帶來(lái)怎樣的變化。

但是,迄今為止,它們?cè)谖谋痉g和圖像、語(yǔ)音識(shí)別領(lǐng)域取得的成功讓我們認(rèn)識(shí)到,深度神經(jīng)網(wǎng)絡(luò)終有一日將會(huì)重塑計(jì)算機(jī)設(shè)計(jì),而這樣的變化對(duì)半導(dǎo)體設(shè)計(jì)和制造領(lǐng)域也同樣有著深遠(yuǎn)的影響。

為 DNNs 量身定制的第一批商用芯片將于今年上市。鑒于它能夠用幾星期或幾個(gè)月時(shí)間來(lái)訓(xùn)練一個(gè)新的神經(jīng)網(wǎng)絡(luò)模型,這些芯片可能是迄今為止制造規(guī)模最大的,因此也可能是成本最高的商用芯片。

今年,這個(gè)行業(yè)會(huì)看到 Graphcore 公司開(kāi)發(fā)的一款非 Dram 模式的微處理器,以及其競(jìng)爭(zhēng)對(duì)手——在圓片級(jí)芯片封裝技術(shù)方面較為領(lǐng)先的 Cerebras Systems 也會(huì)推出一款產(chǎn)品。

與此同時(shí),英特爾收購(gòu)的 2.5-D Nervana 芯片已經(jīng)開(kāi)始取樣,其他諸多廠商的芯片研發(fā)也都在火熱進(jìn)行當(dāng)中。

此外,從 ARM 到西部數(shù)據(jù)(Western Digital),所有老牌半導(dǎo)體巨頭也均在研究處理器核心以加速深度神經(jīng)網(wǎng)絡(luò)的推理部分。

「我認(rèn)為 2018 年,將會(huì)是各種芯片產(chǎn)品『百家爭(zhēng)鳴』的一年。我們開(kāi)始見(jiàn)到許多公司正在評(píng)估各種針對(duì)芯片的 idea,」加州伯克利榮譽(yù)教授 David Patterson 如是說(shuō)道。

這個(gè)趨勢(shì)相當(dāng)明顯,Patterson 與聯(lián)合作者 John Hennessey 在上個(gè)月出版的 Computer Architecture(在計(jì)算領(lǐng)域影響巨大)一書的最新版本中,用整整一個(gè)章節(jié)介紹了這種趨勢(shì)。

作者對(duì)一些內(nèi)部設(shè)計(jì)給出了深度的見(jiàn)解,譬如 Patterson 對(duì)谷歌的TensorFlow Processor(TPU),微軟的 Catapult FPGA,以及蘋果與 Google 最新的手機(jī)芯片中的推理模塊都給出了自己的意見(jiàn)。

Patterson 表示:「這是計(jì)算機(jī)架構(gòu)與封裝技術(shù)的復(fù)興。在明年一年我們將會(huì)看到比過(guò)去十年更多的,更有意思的計(jì)算機(jī)出現(xiàn)?!?

在過(guò)去幾年中,深度神經(jīng)網(wǎng)絡(luò)的興起將風(fēng)投的資金重新帶回到半導(dǎo)體的領(lǐng)域。

在電子工程師時(shí)報(bào)(EE Times)最新發(fā)布的「Silicon 60」中,他們列出了 7 家致力于研究新型神經(jīng)網(wǎng)絡(luò)芯片的初創(chuàng)公司,其中包含了兩個(gè)不太為人所知的公司:

北京的寒武紀(jì)科技與美國(guó)德克薩斯州的 Mythic Inc。

Chris Rowen 從 Cadence Design Systems 離職后,成立了一家名為 Cognite Ventures 的投資公司,專門看神經(jīng)網(wǎng)絡(luò)軟件。

「我們看到具備全新架構(gòu)的新創(chuàng)業(yè)公司如井噴式出現(xiàn)。我自己追蹤了 15 到 20 家公司…在過(guò)去的 10 ~15 年時(shí)間里,在任何半導(dǎo)體子領(lǐng)域里都不曾有過(guò)『同時(shí)出現(xiàn) 15 家半導(dǎo)體公司』這樣的事情?!笴hris Rowen 說(shuō)道。

他表示:「由于英偉達(dá)難以撼動(dòng)的軟件地位,與其在高階服務(wù)器訓(xùn)練方面的競(jìng)爭(zhēng)將會(huì)十分艱難;

而如果你去追求手機(jī)市場(chǎng),那你一定是瘋了,要知道追求手機(jī)市場(chǎng)意味著你必須在很多方面都做得出色。不過(guò)在高階或是低階的手機(jī)市場(chǎng)中,還可能有一些機(jī)會(huì)?!?nbsp;

市場(chǎng)觀察者 The Linley Group 的負(fù)責(zé)人 Linley Gwennap 表示,英偉達(dá)最新的 GPU—Volta 性能非常不錯(cuò),他們對(duì)其進(jìn)行了調(diào)整以進(jìn)行 DNNs 的速度訓(xùn)練。但 Gwennap 卻不認(rèn)為 Volta 就是最好的設(shè)計(jì)。

Gwennap 說(shuō),Graphcore(英國(guó)布里斯托)和 Cerebras(加州洛杉磯)是在訓(xùn)練芯片方面最值得觀察的兩家公司,他們籌集了最多的資金,而且似乎擁有最好的團(tuán)隊(duì)。

此外,由谷歌前芯片設(shè)計(jì)員創(chuàng)立的初創(chuàng)公司 Groq 聲稱將會(huì)在 2018 年推出一款推理芯片,每秒的運(yùn)算和推理都能完勝對(duì)手 4 倍。

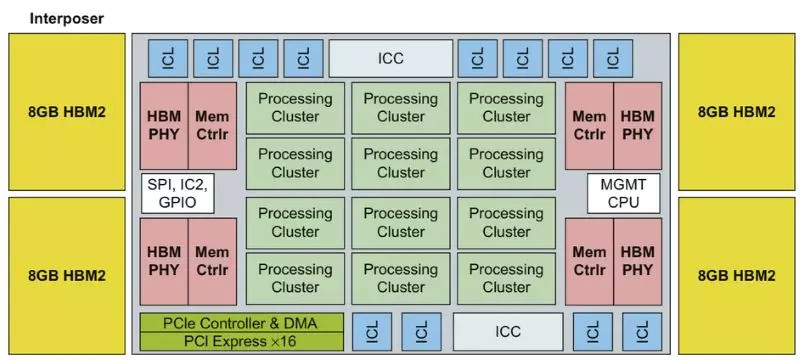

英特爾的 Nervana 是一個(gè)大型的線性代數(shù)加速器,位于一個(gè)硅中介層上,緊鄰著四個(gè) 8GB 的 HBM2 內(nèi)存棧英特爾的 Nervana,被稱為 Lake Crest(上圖),是最受關(guān)注的定制設(shè)計(jì)之一。Nervana 使用數(shù)據(jù)共享指令集中提供的單個(gè) 5 位元指數(shù),執(zhí)行 16 位矩陣操作。

與英偉達(dá)的 Volta 一樣,Lake Crest 的邏輯單元位于一個(gè) TSMC CoWoS 中介層上(芯片-晶片-基板),緊鄰著四個(gè) HBM2 高頻寬內(nèi)存棧。

這些芯片被設(shè)計(jì)成網(wǎng)狀,是 Volta 性能的 5~10 倍。

雖然去年微軟在 DNN 上使用了 FPGA,但是 Patterson 仍然對(duì)這種方法持懷疑態(tài)度?!改銥?FPGA 的靈活性付出了很多的代價(jià);編程真的很困難,」他說(shuō)。

Gwennap 在去年年底的一項(xiàng)分析中指出,DSP 也將會(huì)發(fā)揮作用。「Cadence、Ceva 和 Synopsys 都提供面向神經(jīng)網(wǎng)絡(luò)的 DSP 內(nèi)核」。

AI芯片即將到來(lái),而架構(gòu)師還未決定如何對(duì)其進(jìn)行評(píng)估。

就像 RISC 處理器的早期那樣,Patterson 回憶道:「每一家公司都會(huì)說(shuō),『你可千萬(wàn)不能相信別人的基準(zhǔn)體系,但是你可以相信我的』,這可不太好?!?

時(shí)間退回到那時(shí)候,當(dāng)時(shí) RISC 供應(yīng)商在 SPEC 基準(zhǔn)測(cè)試中進(jìn)行了合作?,F(xiàn)在 DNN 加速器需要定義自己的測(cè)試組件,涵蓋各種數(shù)據(jù)類型的訓(xùn)練、推理。

為了順應(yīng)這種趨勢(shì),12 月 12 日,由 20 多家頂級(jí)服務(wù)器和軟件制造商組成的交易處理性能委員會(huì)(TPC)宣布組建一個(gè)工作組對(duì)機(jī)器學(xué)習(xí)的硬件和軟件基準(zhǔn)進(jìn)行定義。

TPC - AI 委員會(huì)主席 Raghu Nambiar 表示,這個(gè)工作組的目標(biāo)是要?jiǎng)?chuàng)建出對(duì) CPU 和 GPU 加速器通用的測(cè)試。但是,團(tuán)隊(duì)成員名單和時(shí)限仍未最終確定。

百度,于 2016 年 9 月發(fā)布了一個(gè)基于深度學(xué)習(xí)工作負(fù)載的開(kāi)源基準(zhǔn),使用 32 位浮點(diǎn)數(shù)執(zhí)行訓(xùn)練任務(wù)。它在六月份更新了 DeepBench 以涵蓋推理工作并使用 16 位制。

美國(guó)哈佛大學(xué)的研究人員發(fā)表的 Fathom 套件,定義了 8 個(gè)人工智能工作負(fù)載,支持整數(shù)和浮點(diǎn)數(shù)據(jù)。Patterson 說(shuō):「這是一個(gè)開(kāi)始,但是要成為一個(gè)讓人滿意的全面基準(zhǔn)測(cè)試套件,還有很多的工作要做?!?

「如果我們致力于建立一個(gè)好的基準(zhǔn),所有投入工程的錢都會(huì)花在刀刃上?!?

除了基準(zhǔn)之外,工程師需要持續(xù)追蹤不斷變化的神經(jīng)網(wǎng)絡(luò)算法,從而確保他們的設(shè)計(jì)能跟上時(shí)代。

高通公司下一代核心(next-generation-core)研發(fā)總監(jiān) Karam Chatha 表示:

「軟件正在不斷變化,但是我們需要盡早把硬件拿出來(lái),因?yàn)橛布?huì)影響軟件——軟硬件之間總會(huì)有這樣相互牽連的關(guān)系?!?

到目前為止,這家移動(dòng)芯片供應(yīng)商仍在驍龍?zhí)幚砥鞯?DSP 和 GPU 內(nèi)核的軟件平臺(tái)上進(jìn)行神經(jīng)網(wǎng)絡(luò)運(yùn)行工作。

但是一些觀察人士預(yù)計(jì),高通將為機(jī)器學(xué)習(xí)定制一個(gè)全新的模塊。在 2019 年,該模塊將成為驍龍?zhí)幚砥髦幸粋€(gè)大約 7 豪微米的部分。

高通展示了一個(gè) DNN 定制加速器研究實(shí)例,但現(xiàn)在,高通在使用通用 DSP 和 GPU 內(nèi)核上的軟件

Patterson 表示:「市場(chǎng)是芯片質(zhì)量的檢驗(yàn)者。這很殘酷,但也正是計(jì)算機(jī)設(shè)計(jì)讓人興奮的地方?!?

實(shí)際上,早期的芯片玩家已經(jīng)抓住了這次競(jìng)爭(zhēng)的機(jī)遇。

舉例來(lái)說(shuō),F(xiàn)acebook 最近證明,通過(guò)大幅增加所謂批量尺寸(batch size)中的特征數(shù)目,能將某些任務(wù)的訓(xùn)練時(shí)間從一天縮短到一小時(shí)。

但這對(duì)于芯片制造商 Graphcore 而言可能是個(gè)壞消息。因?yàn)?Graphcore 試圖將所有操作放在本地 SRAM 中運(yùn)行,以消除外部 DRAM 的訪問(wèn)延遲,但與此同時(shí)也會(huì)限制其內(nèi)存占用。

Patterson 說(shuō)道:「Graphcore 專為小批量設(shè)計(jì),但是幾個(gè)月前軟件結(jié)果表明,大批量尺寸效果更好。事情總是瞬息萬(wàn)變。」

另一方面,Rex Computing 認(rèn)為他們正好抓住了有利的機(jī)遇。該初創(chuàng)公司的 SoC 最初為高性能服務(wù)器設(shè)計(jì),其中使用了一種新型暫存器內(nèi)存。

Rex Computing 聯(lián)合創(chuàng)始人 Thomas Sohmers 表示,Rex 的方法消除了在虛擬頁(yè)表中對(duì)數(shù)據(jù)緩存的需求,這是一種在 GPU 中使用的技術(shù),能增加延遲。

因此,Thomas Sohmers 說(shuō),尤其在處理當(dāng)下神經(jīng)網(wǎng)絡(luò)中流行的矩陣運(yùn)算和矢量運(yùn)算時(shí),Rex 芯片性能遠(yuǎn)勝于現(xiàn)在的 GPU。

該初創(chuàng)公司計(jì)劃于 6 月份推出 256 核的 16-nm SoC,希望其能效比能達(dá)到 256 Gflops/W。

與此同時(shí),研究人員正在嘗試單比特浮點(diǎn)數(shù)、 32 比特浮點(diǎn)數(shù)以及整型等各種精度的計(jì)算,旨在尋找神經(jīng)網(wǎng)絡(luò)計(jì)算中效率最高的方法。

看起來(lái)他們?cè)谀骋稽c(diǎn)上達(dá)成了一致,即不要在不同的精度等級(jí)間進(jìn)行轉(zhuǎn)換。

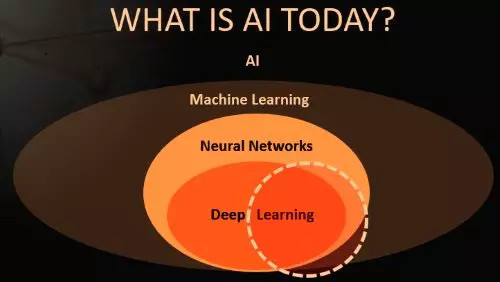

幾十年來(lái),深度神經(jīng)網(wǎng)絡(luò)一直是人工智能領(lǐng)域中的一個(gè)小分支。

自 2012 年左右開(kāi)始,包括 Facebook 的 Yann LeCun 在內(nèi)的研究人員開(kāi)始使用特定種類的 DNN 進(jìn)行圖像識(shí)別,最終獲得了比人類更高的準(zhǔn)確率,顯示出驚人的成果。

深度學(xué)習(xí)技術(shù)吸引了學(xué)界,現(xiàn)在學(xué)術(shù)圈正在高速發(fā)表論文,尋求新的突破。

如今,DNN 正在提供商業(yè)化服務(wù),如亞馬遜的 Alexa 、谷歌翻譯、Facebook 面部識(shí)別等。網(wǎng)絡(luò)巨頭和全球其他競(jìng)爭(zhēng)者正競(jìng)相將這些技術(shù)應(yīng)用于各種服務(wù)中,盡其所能尋找殺手級(jí)應(yīng)用。

微軟每年都會(huì)在人工智能方面主持兩場(chǎng)僅員工參與的會(huì)議。前 SPARC 處理器架構(gòu)師 Marc Tremblay 表示,上一場(chǎng)會(huì)議有 5000 人參加。Marc Tremblay 現(xiàn)在正帶領(lǐng)微軟進(jìn)行 AI 專用芯片和系統(tǒng)方面的工作。

專家們承認(rèn),他們并不完全理解現(xiàn)有算法為何能得到良好的效果。

這質(zhì)疑了 DNN 及其他各類模式的相對(duì)有效性,例如循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)和卷積神經(jīng)網(wǎng)絡(luò)(CNN)等。與此同時(shí),學(xué)者還在不斷發(fā)明新的模式。

「算法在五年內(nèi)會(huì)發(fā)生變化的可能性很高。我們正在進(jìn)行一場(chǎng)賭博——像矩陣乘法這樣的最底層?xùn)|西是不可改變的?!乖谧罱P(guān)于人工智能的 IEEE 研討會(huì)上,AMD 公司研究員 Allen Rush 這樣說(shuō)。

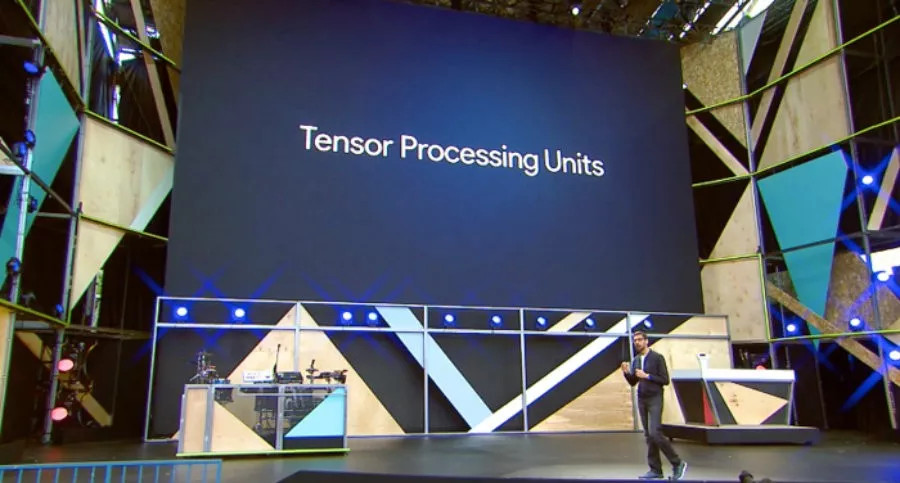

這就是 Google 用 TPU 做的賭注。

最新版本的 TPU 是能同時(shí)針對(duì)訓(xùn)練和推理工作。本質(zhì)上說(shuō),TPU 是一個(gè)巨大的乘加單元陣列,對(duì)矩陣操作進(jìn)行運(yùn)行和存儲(chǔ)。預(yù)計(jì) Nervana 和 Graphcore 的芯片將效仿這一模式。

哈佛大學(xué)前大腦研究員、Nervana 的聯(lián)合創(chuàng)始人 Amir Khosrowshahi,目前正在英特爾 Nervana 集團(tuán)任首席技術(shù)官。

他說(shuō),目前在神經(jīng)網(wǎng)絡(luò)方面取得的成功占據(jù)了人工智能領(lǐng)域成果的絕大部分。他在 IEEE 研討會(huì)上表示:

「由于深度學(xué)習(xí)的極大成功,我們對(duì)很多領(lǐng)域都避而不談。當(dāng)下,人人都在研究 CNN,這是一場(chǎng)悲劇……不要以為現(xiàn)在的熱潮會(huì)一直持續(xù)到明年?!?

如今的 DNN 受到了極大的關(guān)注,但是它只代表人工智能廣泛領(lǐng)域中的一小部分

盡管 DNN 在圖像識(shí)別方面比人類有著更高的精確率,「但如今的數(shù)據(jù)科學(xué)家不得不花費(fèi)過(guò)長(zhǎng)的時(shí)間對(duì)數(shù)據(jù)進(jìn)行預(yù)處理,對(duì)模型和參數(shù)進(jìn)行迭代,并且等待訓(xùn)練收斂……其中,每個(gè)步驟要么有著過(guò)于密集的勞動(dòng),要么有著過(guò)于密集的計(jì)算量」,Khosrowshahi 說(shuō)道。

總而言之,他補(bǔ)充說(shuō):「人工智能領(lǐng)域仍面臨著許多難題。頂尖研究者能讓機(jī)器人打開(kāi)一扇門,但是讓機(jī)器人端起茶杯可能比打敗 AlphaGo 困難得多?!?

在這種環(huán)境下,F(xiàn)acebook 和 Google 等網(wǎng)絡(luò)巨頭正在發(fā)布大量的數(shù)據(jù)集,讓更多的人從事前沿問(wèn)題,例如將識(shí)別應(yīng)用于視頻等新興領(lǐng)域或其他數(shù)據(jù)類型。

隨著算法的不斷發(fā)展,研究人員也在拓展深度學(xué)習(xí)的應(yīng)用邊界。

谷歌致力于將深度神經(jīng)網(wǎng)絡(luò)系統(tǒng)性地應(yīng)用于一系列問(wèn)題,比如為盲人用戶自動(dòng)添加圖片說(shuō)明文字、解讀核磁共振成像的掃描結(jié)果,以及輔助工廠的質(zhì)量控制監(jiān)督工作。

「人工智能并非一種單一的技術(shù)或產(chǎn)品,」谷歌研發(fā)部負(fù)責(zé)人李佳告訴 IEEE 研討會(huì),「我們需要先理解那個(gè)領(lǐng)域,然后收集數(shù)據(jù)、找出適配算法并提出解決方案。每一個(gè)新問(wèn)題都需要一個(gè)不同的模型?!?

事實(shí)上,業(yè)界正在將深度神經(jīng)網(wǎng)絡(luò)系應(yīng)用于幾乎任何領(lǐng)域,包括芯片的設(shè)計(jì)與制作。英特爾列出了 40 多個(gè)可能的應(yīng)用方向,從消費(fèi)者在線購(gòu)物助理,到華爾街自動(dòng)交易程序。

現(xiàn)任 Target 數(shù)據(jù)科學(xué)家的 Shirish Tatikonda,曾在 IBM 做研究員,對(duì)深度神經(jīng)網(wǎng)絡(luò)的應(yīng)用邊界有著更加清醒的認(rèn)識(shí)。

他在一次簡(jiǎn)短的采訪中談到,零售商的大多數(shù)數(shù)據(jù)都是有關(guān)聯(lián)的,不是那種最適合于神經(jīng)網(wǎng)絡(luò)的非結(jié)構(gòu)化類型;在 Target 所接手的業(yè)務(wù)問(wèn)題中,只有 10% 適用于深度神經(jīng)網(wǎng)絡(luò)。

盡管如此,Target 公司仍在積極探索該領(lǐng)域,其大約 10% 的系統(tǒng)使用的是 GPU 服務(wù)器,用于訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型。

為了實(shí)現(xiàn)規(guī)模化,谷歌的研究人員正致力于探究被其稱為 AutoML 的軟件。其思想是使用神經(jīng)網(wǎng)絡(luò)來(lái)自動(dòng)生成模型,無(wú)需數(shù)據(jù)科學(xué)家對(duì)其進(jìn)行手動(dòng)調(diào)整。

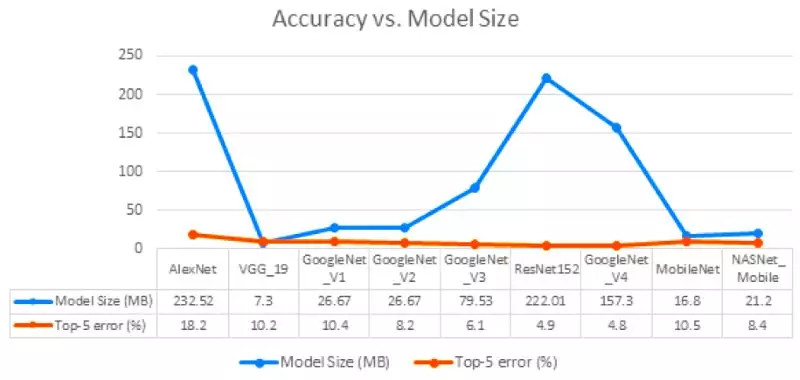

雖然近年來(lái)有許多研究人員尋求減少深度神經(jīng)網(wǎng)絡(luò)模型的內(nèi)存占用,但其尺寸差異仍然十分巨大

機(jī)器人先驅(qū) Rodney Brooks 擔(dān)心,業(yè)界對(duì)這種算法的預(yù)期可能過(guò)于樂(lè)觀了。他在最近的一次談話中說(shuō):「深度學(xué)習(xí)很好,但它正被當(dāng)成萬(wàn)靈藥。」

就 Patterson 而言,他仍然選擇保持樂(lè)觀。雖然廣博的人工智能領(lǐng)域沒(méi)有兌現(xiàn)過(guò)去的一些承諾,但它在機(jī)器翻譯等領(lǐng)域所取得的成功卻是真實(shí)的。

「你可以說(shuō)好采的果子都被采完了,不會(huì)再有更令人興奮的事情了,但事實(shí)上幾乎每周都會(huì)出現(xiàn)新的進(jìn)展...... 所以我想我們會(huì)發(fā)現(xiàn)更多的用途?!?

深度學(xué)習(xí)的早期發(fā)展充溢著狂熱與碎片化,即使軟件融合工作都被搞得支離破碎。

百度的人工智能研究小組進(jìn)行了一項(xiàng)調(diào)查,提出 11 項(xiàng)舉措來(lái)彌合不同神經(jīng)網(wǎng)絡(luò)管理軟件框架之間的隔閡。

Facebook、微軟以及新近加入的亞馬遜發(fā)起了一個(gè)比較靠譜的開(kāi)源解決方案,叫做開(kāi)源神經(jīng)網(wǎng)絡(luò)交換(Open Neural Network Exchange,ONNX)。

該項(xiàng)目在 12 月發(fā)布了 ONNX 的 1.0 版。其目標(biāo)是將軟件框架領(lǐng)域的 12 家競(jìng)爭(zhēng)廠商所創(chuàng)建的神經(jīng)網(wǎng)絡(luò)模型轉(zhuǎn)化為一種圖形表示。芯片制造商可以使用這種圖形表示來(lái)進(jìn)行硬件開(kāi)發(fā)。

對(duì)于初創(chuàng)企業(yè)來(lái)說(shuō),無(wú)論是亞馬遜的 MxNet 或谷歌的 TensorFlow,還是 Facebook 的 Caffe2 或微軟的 CNTK,這些競(jìng)爭(zhēng)廠商所編寫的模型框架都很難互相兼容,而它們也無(wú)力編寫單獨(dú)的軟件,ONNX 無(wú)疑是一個(gè)福音。

12 月 20 日,由 30 多個(gè)主要的芯片廠商組成的一個(gè)研究小組發(fā)布了他們的首選方案——神經(jīng)網(wǎng)絡(luò)交換格式(Neural Network Exchange Format,NNEF)。

NNEF 旨在為芯片制造商提供一種個(gè)性化的選擇,使他們能夠創(chuàng)建屬于自己的、供內(nèi)部員工使用的格式,比如英特爾的 Nervana Graph 和英偉達(dá)的 TensorRT。

百度創(chuàng)建的格式有 ISAAC、NNVM、Poplar 和 XLA。

「置于哪一個(gè)將被成功實(shí)施,現(xiàn)在還不好說(shuō),但我們正在穩(wěn)步前進(jìn),而最終一定會(huì)有一個(gè)從中脫穎而出,」百度的硅谷人工智能實(shí)驗(yàn)室高級(jí)研究員 Greg Diamos 說(shuō)道。

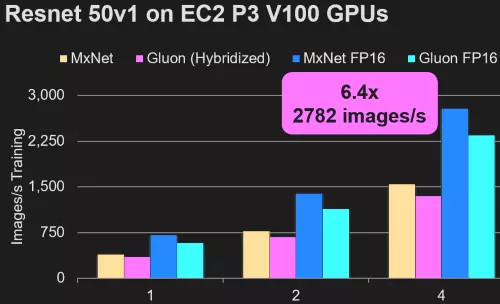

在人工智能框架方面,亞馬遜聲稱其 MxNet 框架及其新開(kāi)發(fā)的 Gluon API 效率最高

另外,谷歌已經(jīng)開(kāi)始致力于自動(dòng)化深度神經(jīng)網(wǎng)絡(luò)模型的簡(jiǎn)化過(guò)程,以便在智能手機(jī)、物聯(lián)網(wǎng)(IoT)節(jié)點(diǎn)等任何平臺(tái)上運(yùn)行。

如果該項(xiàng)目成功的話,可以將 50 兆字節(jié)的模型縮小到只有 500 字節(jié)。

谷歌也在探索如何在手機(jī)端進(jìn)行有限模型訓(xùn)練,其方法是調(diào)整模型的頂層網(wǎng)絡(luò),或是在白天收集數(shù)據(jù),然后在夜間運(yùn)行流程。

同樣,SqueezeNet 和 MobileNet 等業(yè)界同行也在開(kāi)發(fā)類似的成像模型,精度與其科技界的大表哥們不相上下。

「我們已經(jīng)看到,機(jī)器學(xué)習(xí)正被大量應(yīng)用在五花八門的產(chǎn)品中,」谷歌的 TensorFlow Lite 負(fù)責(zé)人 Pete Warden 說(shuō)道,「支持我徹夜工作的動(dòng)力,就是能夠降低一絲一毫的運(yùn)算能耗。」

當(dāng)專家們專注于探索人工智能的未來(lái)時(shí),他們看到了一些有趣的可能性。

目前,我們所使用的有監(jiān)督學(xué)習(xí)是基于手動(dòng)調(diào)整。

Warden 是谷歌的一名研究人員,他和同事們都認(rèn)為,不久的將來(lái)會(huì)出現(xiàn)一些半監(jiān)督的學(xué)習(xí)方式,例如手機(jī)等客戶端設(shè)備可以獨(dú)自處理一些學(xué)習(xí)任務(wù)。

而最終的目標(biāo)是無(wú)監(jiān)督學(xué)習(xí)——即計(jì)算機(jī)自學(xué),無(wú)需工程師的幫助。

一直以來(lái),研究人員都希望能夠?qū)ふ页鲆环N方法,使手機(jī)或物聯(lián)網(wǎng)節(jié)點(diǎn)等設(shè)備在收集數(shù)據(jù)時(shí)可以自動(dòng)對(duì)其進(jìn)行標(biāo)記。

「谷歌認(rèn)為,在這個(gè)中間階段,我們現(xiàn)在需要進(jìn)行大量的計(jì)算,但是一旦可以自動(dòng)標(biāo)記數(shù)據(jù),你就只需要索引新的增量?jī)?nèi)容,這更像是人類的數(shù)據(jù)處理方式,」Western Digital 首席數(shù)據(jù)科學(xué)家 Janet George 說(shuō)道。

無(wú)監(jiān)督學(xué)習(xí)打開(kāi)了一扇通往加速機(jī)器智能時(shí)代的大門,有些人將其看作是數(shù)字天堂。

而另一些人則擔(dān)心,缺少人為干預(yù)的技術(shù)可能會(huì)失控,從而帶來(lái)災(zāi)難性的后果?!高@就是我害怕的地方,」處理器領(lǐng)域資深老兵 Norm Jouppi 說(shuō)道,他曾領(lǐng)導(dǎo)了谷歌的 TPU 項(xiàng)目。

與此同時(shí),從事半導(dǎo)體研究的學(xué)術(shù)工作者對(duì)于未來(lái)的人工智能芯片有著自己的長(zhǎng)遠(yuǎn)設(shè)想。

現(xiàn)在,英特爾、Graphcore 和英偉達(dá)「已經(jīng)在制造全刻線(full-reticle)芯片,下一步就是三維技術(shù),」Patterson 說(shuō)道,

「在摩爾定律當(dāng)?shù)罆r(shí),人們會(huì)比較排斥復(fù)雜的芯片封裝技術(shù),對(duì)其可靠性和成本問(wèn)題有所顧忌。現(xiàn)在摩爾定律已經(jīng)終結(jié)了,芯片封裝領(lǐng)域?qū)?huì)出現(xiàn)很多其它的創(chuàng)新性實(shí)踐。」

最終任務(wù)是創(chuàng)造新型的晶體管,使其可以堆疊在由邏輯和存儲(chǔ)器組成的裸片層上。

Suman Datta 是 Notre Dame 學(xué)院的一名電氣工程學(xué)教授,他認(rèn)為負(fù)電容鐵電晶體管很適于創(chuàng)建這類芯片。

在最近一次有關(guān)所謂的單片 3D 架構(gòu)的會(huì)議上,他談到了該領(lǐng)域的未來(lái)發(fā)展圖景。這種設(shè)計(jì)利用并提高了三維 NAND 閃存在芯片堆棧中的效益。

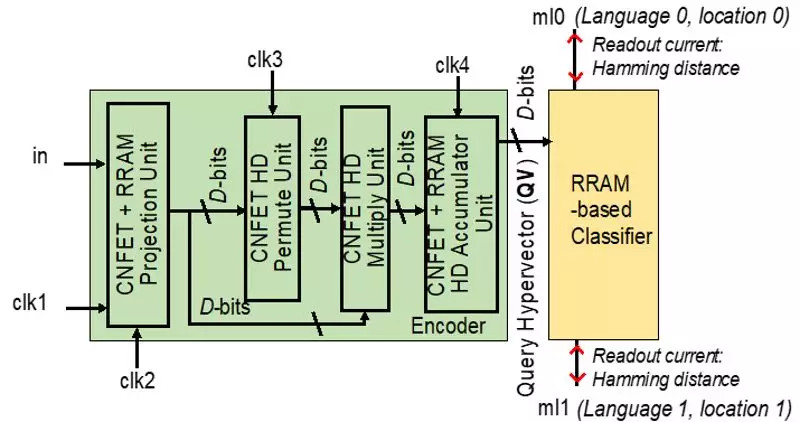

在今年 2 月舉行的國(guó)際固態(tài)電路會(huì)議(International Solid-State Circuits Conference)上,來(lái)自伯克利、麻省理工和斯坦福大學(xué)的一個(gè)團(tuán)隊(duì)將提出一種體系架構(gòu),同樣富有遠(yuǎn)見(jiàn)。

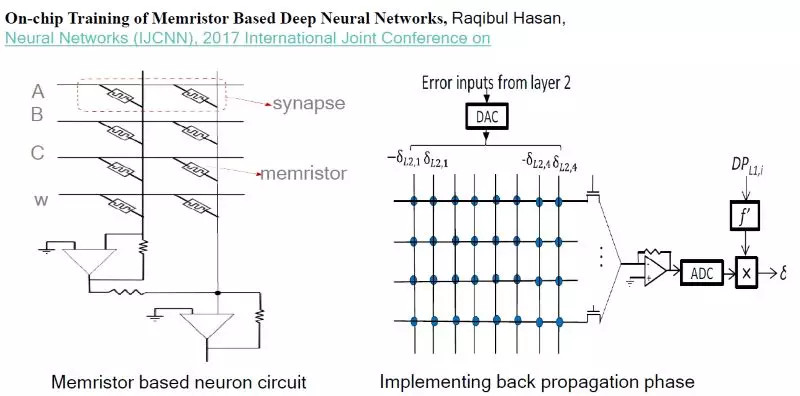

芯片(下圖)在帶有碳納米管制邏輯的裸片上,堆疊了電阻式 RAM(Resistive Random Access Memory,ReRAM)結(jié)構(gòu)。

來(lái)自上述三校的研究人員將在 ISSCC 上介紹一種新型加速器,它使用碳納米管、ReRAM 以及模式作為計(jì)算元素

受深度神經(jīng)網(wǎng)絡(luò)的啟發(fā),該裝置采用的是近似模式,而非計(jì)算機(jī)一直以來(lái)所使用的確切數(shù)字。

這個(gè)所謂的高維計(jì)算使用成千上萬(wàn)維向量作為計(jì)算元素,伯克利教授 Jan Rabaey 說(shuō)道,他也是該論文的貢獻(xiàn)者之一,并且是英特爾的智能咨詢委員會(huì)成員。

這種芯片可以從案例中進(jìn)行學(xué)習(xí),且其所需的操作次數(shù)遠(yuǎn)遠(yuǎn)少于傳統(tǒng)系統(tǒng),Rabaey 說(shuō)。在一個(gè)關(guān)聯(lián)的內(nèi)存陣列中,流片前的測(cè)試芯片將使用陣列振蕩器作為與 ReRAM 單元配對(duì)的模擬邏輯。

「我夢(mèng)想中的引擎在場(chǎng)邊給我作指導(dǎo)…... 我的目標(biāo)是把人工智能的操作能耗降低到 100 毫伏以下,」Rabaey 在 IEEE 人工智能研討會(huì)上說(shuō),

「我們需要重新思考我們的計(jì)算方式。我們的關(guān)注點(diǎn)正在從算法轉(zhuǎn)向基于數(shù)據(jù)的系統(tǒng)?!?

2017-01-29 來(lái)源:36氪